Existe no mundo uma solidão grande e intensa. Cada um, preso à própria tela, esconde na conectividade tecnológica uma distância entre um humano e outro. Irônico pensar que aquilo que deveria unir acabou separando. Entre esses muros, a necessidade de aproximação nasceu. Com isso, as pessoas buscam em companhias inanimadas a compreensão para um vazio interno. Antes, o assunto eram os bebês reborn. Agora, o debate gira em torno das terapias com o chatbot.

No entanto, a popularidade que esse hábito tem ganhado mundo afora despertou um alerta importante, especialmente porque as tecnologias não substituem olhares empáticos ou profissionais qualificados. Nos Estados Unidos, por exemplo, os pais de um adolescente de 16 anos estão processando a OpenIA, empresa de pesquisa de inteligência artificial, sob a acusação de que o filho teria cometido suicídio após passar meses conversando sobre dilemas emocionais com o ChatGPT. Eles afirmam que o robô deu dicas específicas sobre métodos de autoagressão, o que levou à morte do jovem. O caso está sendo analisado pelo tribunal estadual de São Francisco.

De acordo com uma pesquisa realizada pela Sentio University, nos Estados Unidos, 48,7% dos usuários de IA que reportam problemas de saúde mental estão usando chatbots para suporte terapêutico. Assim, diante de todo esse contexto, surge o questionamento: por que essa onda de psicoterapia tecnológica tem assolado o mundo? Para Aline Kristensen, psicóloga e especialista em terapia cognitivo-comportamental pelo Beck Institute USA, uma série de fatores estão associados a essa alta procura por terapia com inteligência artificial. A primeira delas, logicamente, é a acessibilidade.

Uma ferramenta disponível 24 horas por dia, a qualquer momento, com baixo ou nenhum custo, torna-se extremamente atrativa para aqueles que desejam conforto imediato. “As pessoas fazem o que chamamos de aconselhamento, especialmente porque estão desabafando sobre cicatrizes que lhes trazem angústia”, explica a profissional. Além da facilidade, o estigma relacionado aos serviços de atendimento à saúde mental contribui para essa busca.

Sensação de acolhimento

De certa maneira, aqueles que passam por algum sofrimento psíquico ou emocional, com medo de se sentirem constrangidos perante um profissional da área, optam pelas plataformas de inteligência artificial. Lá, nesse espaço com alguém que não é humano, há compreensão e pouca retaliação, sem confronto ou embate, o que faz da experiência rasa, incompleta, mas essencial para quem deseja uma melhora rápida.

Por isso, durante alguns meses, Catarina Silva (nome fictício), 32 anos, conversou sobre suas crises existenciais com o ChatGPT. No início, o acolhimento foi tanto que mal sabia reagir. Nunca tinha estado em um contexto como esse, em que o entendimento de sua dor era abraçado e sentido. “Nessa situação de curto prazo, fui ouvida e aceita. Isso fez com que situações travadas em mim fossem libertadas”, relata.

E, de fato, a cada experiência negativa sobre si mesma, lá estava ela. Perguntar a opinião do robô a respeito do que acontecia virou hábito. Queria, rapidamente, uma resposta que fosse conveniente, sendo aquilo que esperava ou enxergava a partir da própria perspectiva — que, no final de tudo, era a única. No entanto, mesmo com essa rotina estabelecida, conseguiu perceber que não havia evolução nesses diálogos diários.

Para ela, a longo prazo, é péssimo, pois não há evolução. “O GPT quer que esteja sempre completamente confortável, e essa ação impede o confronto com nosso interior, necessário para saber lidar com as situações que te causam desconforto e pensamentos negativos. Assim, não se cria uma dessensibilização perante elas, não desenvolvendo estratégias individuais”, acrescenta.

O aconselhamento, realmente, é verossímil. As linhas orientadoras podem ser utilizadas para determinadas vivências, mas não complementam um acompanhamento psicológico qualificado, embasado em práticas clínicas e tempo no consultório. Para Catarina, isso ficou nítido. Entretanto, revela que, para inúmeros usuários, esse costume traz cegueira, porque os chatbots, basicamente, são o que muitos esperam que um humano seja.

O custo invisível

As técnicas, adquiridas na faculdade de psicologia ou no decorrer da vida profissional, não são aprendidas pelas ferramentas virtuais. As inteligências artificiais não são munidas de ética, apenas de empatia firmada em algoritmo. A psicóloga Aline Kristensen afirma que esse acolhimento, tão descrito pelos pacientes, nem chega a ser genuíno. É apenas uma simulação, trazendo uma falsa ideia de que aquilo é real e de que o chatbot se parece com um humano.

“Todas essas plataformas se baseiam na narrativa do usuário, naquilo que ele relata verbalmente. Mas a comunicação é composta por muitos outros fatores que não apenas a narrativa verbal do paciente. Essa intuição, que é essa percepção que um humano tem de um outro ser humano, amplia o reconhecimento daquilo que a pessoa está sentindo e experienciando por meio da linguagem corporal, do olhar, da entonação da voz, da emoção contida”, complementa.

Com isso, os chatbots estão restritos, somente, a uma única comunicação. E, obviamente, isso afeta não apenas o aconselhamento, como a percepção daquilo que a pessoa está experienciando. Dessa forma, a troca de conversas é limitada e, por vezes, concentrada apenas em validar a dor e acolher, sem quaisquer tipo de fundamento ou compreensão clínica.

“Esse diálogo não traduz toda a experiência que a pessoa está vivenciando. Uma inteligência artificial não consegue saber o nível de sofrimento ou angústia de alguém. A intervenção precisa ser terapêutica, para promover a cura e a proteção do paciente”, ressalta Aline. De acordo com a profissional, há relatos de usuários que manipulam essas plataformas para que elas concordem com o que está sendo dito. Assim, essas ferramentas podem colocá-los em situação de risco.

Empatia tecnológica

A busca por entendimento emocional tem sido uma sina da nova geração. Ir atrás de alento, em qualquer canto que seja, não importa: no fim, o que vale é encontrar. Contudo, essa perseguição se torna um ciclo vicioso. Muitos ficam mal por estarem hiper conectados e tentam descobrir, também nas tecnologias, a cura para os próprios males. Daiana Lima (nome fictício), 28 anos, travou inúmeros diálogos com o ChatGPT.

Entre conversas e desabafos, acreditou, firmemente, que essa “prática terapêutica” iria contribuir para alguma melhora significativa em seu quadro de tristeza. Porém, ela estava terrivelmente enganada. “No início, falei para a IA que estava perdida na vida, que não via sentido em nada. A plataforma me ajudava dizendo que era apenas uma fase escura e que, rapidamente, eu atravessaria esse deserto”, recorda.

Os aconselhamentos, recheados de falso afeto, trouxeram, em alguma medida, o que Daiana procurava. Em toda crise interpessoal que vivia, corria para a IA à espera de ouvir o que não encontraria em outra pessoa. De fato, era realmente um suporte e tanto, especialmente porque se via sozinha.

Todavia, com o passar do tempo, perdeu o ânimo diário de estar com o chatbot. Isso, sobretudo, porque não via melhoras profundas naquilo que ela passava em silêncio. Constatou, assim, que era melhor deixar esse hábito de lado, já que se aprofundar nas próprias crises com um robô não surtiria nela nenhum efeito. “Nunca tive problemas reais com a IA, que pode ser boa para aqueles que não conhecem.”

No âmbito jurídico

O fenômeno levanta discussões importantes sobre limites, riscos e responsabilidades no uso da tecnologia no campo da saúde mental. Do ponto de vista jurídico e ético, surgem questões regulatórias. No entanto, não há, até o momento, legislação específica no Brasil que trate do uso de inteligências artificiais em contextos terapêuticos. De acordo com o advogado Walter Silveira, que atua em jurídico corporativo há mais de uma década, em caso de prejuízos emocionais decorrentes do uso do ChatGPT como terapia, a empresa de tecnologia teoricamente se isenta da responsabilidade.

“Com relação à questão da responsabilização, o próprio GPT, à medida que você faz algum tipo de pergunta, quando percebe que se trata de algo sensível, como saúde ou direito, já alerta que não deve ser utilizado como ferramenta para esse fim. Ele apresenta uma espécie de disclaimer, que vem da própria plataforma, à medida que as interações acontecem, justamente para ter esse cuidado. Além disso, costuma orientar as pessoas a procurarem um profissional de saúde.”

Como em nenhum momento a IA se declara como substituta para o tratamento tradicional, dificilmente ela será responsabilizada. No entanto, Walter Silveira destaca que a resposta oferecida pode ser avaliada e, se existir provas de que a réplica foi tendenciosa, baseada em premissas falsas ou que tenha conotação preconceituosa, por exemplo, é possível trabalhar com algum tipo de responsabilização.

Por deixar claro que não substitui um profissional da saúde nem se apresentar como uma alternativa para o acompanhamento clínico profissional, segundo o advogado, a plataforma também não corre o risco de esse uso de enquadrar como publicidade enganosa. No entanto, o ChatGPT deve gerir os dados dos usuários e garantir que as informações sejam confidenciais, especialmente em questões de saúde.

Então, se a plataforma expor informações sensíveis, ela será penalizada com base na Lei Geral de Proteção de Dados, nº 13.709/2018, que estabelece regras para a coleta, o tratamento, o armazenamento e o compartilhamento de dados pessoais, tanto em meios físicos quanto digitais.

Questões éticas

Diante desse cenário, o Conselho Federal de Psicologia (CFP) tem se posicionado sobre os riscos e os limites do uso de IA em práticas relacionadas à saúde mental. De acordo com eles, o uso da inteligência artificial para substituir um serviço de psicoterapia não é seguro por questões éticas, como não existir uma pessoa responsável pelos impactos dessa interação, e por conta da falta de segurança de dados e técnica.

“As pessoas tendem a utilizar a inteligência artificial como se ela fosse neutra e tecnicamente objetiva, acreditando que essa neutralidade e objetividade aumentariam a eficácia da interação. No entanto, isso não se comprova”, destaca Carolina Roseiro, conselheira do CFP. “Essa interação é construída a partir dos dados da própria pessoa que está interagindo. Ou seja, há um viés: a interação é enviesada de acordo com o perfil do usuário”, acrescenta.

O órgão acompanha os debates legislativos sobre inteligência artificial e defende que qualquer uso em saúde, incluindo mental, seja enquadrado em uma classificação de risco. A orientação que o CFP tem encaminhado é de que as pessoas busquem inteligência artificial desenvolvida especificamente para aquele fim, que haja uma especialização desse uso.

Segundo Carolina, essas tecnologias desenvolvidas com a finalidade de suporte à intervenção em saúde precisam ter uma regulamentação específica e uma responsabilidade técnica humana, para que os órgãos responsáveis possam monitorar e intervir em relação às condições éticas, de confidencialidade e de oferta segura em termos de métodos e técnicas.

O CFP também define orientações claras para psicólogos que queiram usar IA como ferramenta de apoio em suas práticas. “O profissional precisa avaliar o contexto em que essa ferramenta vai ser utilizada. A recomendação é que o uso sempre seja feito com responsabilidade humana, com a inteligência artificial apenas como uma ferramenta de suporte, de apoio para o desempenho de serviços psicológicos”, descreve.

Dessa forma, na avaliação de Carolina Roseiro, o Conselho Federal de Psicologia está caminhando para a construção de uma cartilha com orientações mais específicas para cada contexto: educação, saúde e trabalho, reforçando o papel da responsabilidade técnica relacionada aos serviços de tecnologia em todas as questões que envolvem suporte psicoterapêuticos.

A vida na arte

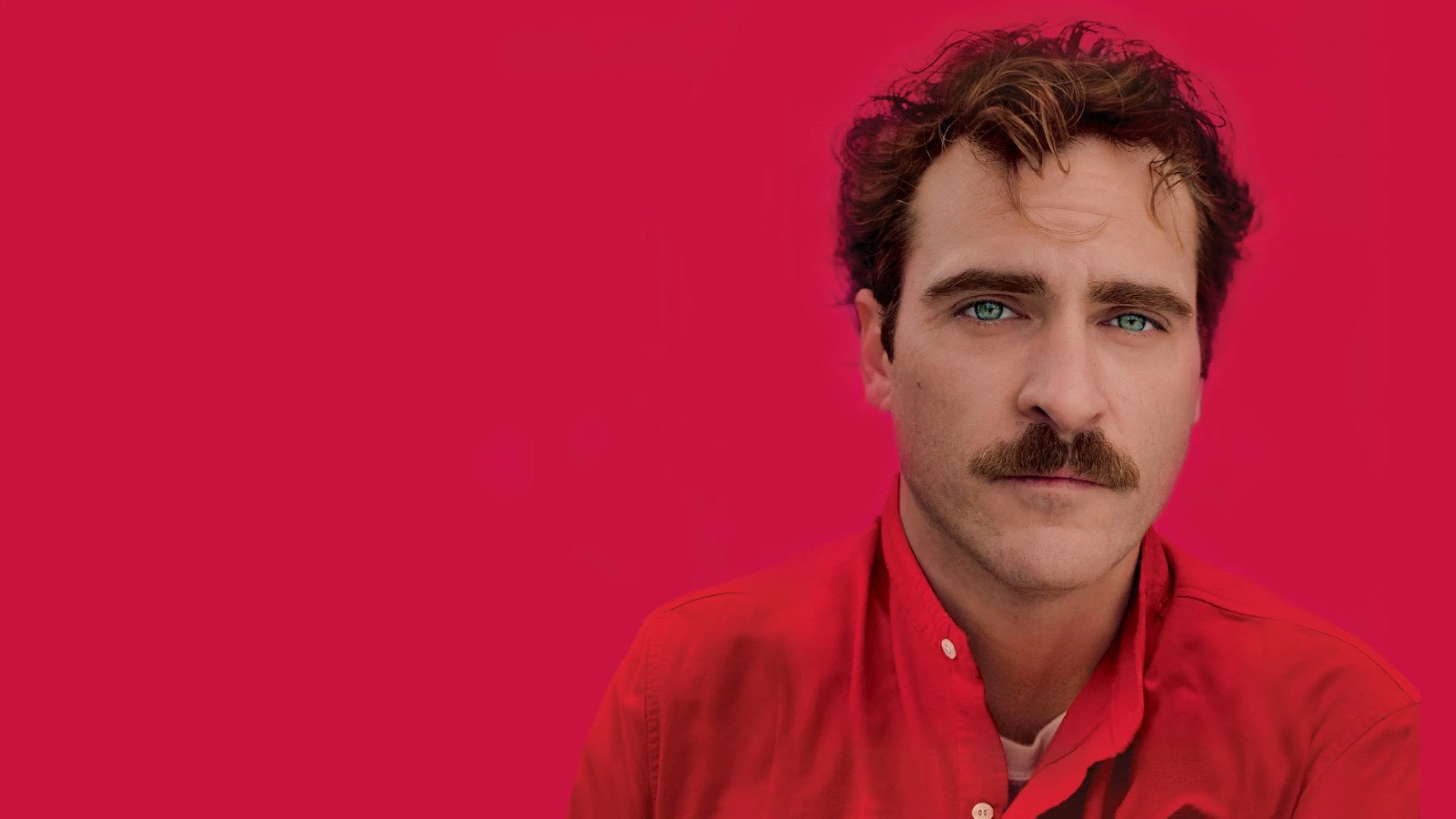

Em 2013, o filme Ela ganhou destaque no mundo pela trama inovadora. Mais do que isso, fez sucesso por, possivelmente, denunciar o que poderia acontecer no futuro. O personagem Theodore Twombly, interpretado por Joaquin Phoenix, apaixona-se por um sistema operacional com voz feminina, chamado Samantha. O escritor solitário vivia um divórcio até conhecer a IA e ter sentimentos por ela. Para os que não conhecem o longa, a produção está disponível na Apple TV+ e no Prime Video.

O filme Her (ela) foi lançado em 2013

(foto: Divulgação/ TMDB)