No início da década de 2010, quando a inteligência artificial começou a ganhar força, processadores convencionais (CPUs) e placas gráficas (GPUs) eram suficientes para rodar redes neurais simples, geradores de imagens e os primeiros modelos de linguagem.

Mas, em 2025, a chegada dos agentes de IA – modelos capazes de pensar, planejar e agir de forma autônoma e em tempo real – mudou radicalmente esse cenário.

“Estamos caminhando para um futuro no qual centenas de modelos especializados, os chamados agentes, vão colaborar entre si para resolver problemas – como acontece em equipes humanas”, explica Vamsi Boppana, vice-presidente sênior da divisão de IA da AMD.

“Quando esses modelos interagem, os gargalos de latência típicos do processamento tradicional começam a desaparecer. Essa comunicação entre máquinas está abrindo caminho para um novo nível de inteligência”, complementa.

À medida que empresas adotam agentes de IA em operações em tempo real, fica claro que a verdadeira autonomia exige uma nova base tecnológica.

“A transição da inferência estática para agentes autônomos está colocando uma pressão sem precedentes sobre a infraestrutura, com a demanda por processamento, memória e conectividade crescendo de forma acelerada em todas as áreas”, acrescenta Boppana.

Quanto mais rápida a inferência, mais eficiente é a IA.

Para dar conta dessas novas exigências, o setor está migrando para chips personalizados, projetados especificamente para agentes autônomos. Gigantes da tecnologia como Meta, OpenAI, Google, Amazon e Anthropic estão desenvolvendo juntas o hardware, a infraestrutura e os sistemas de controle que darão vida à primeira força de trabalho digital verdadeiramente autônoma do mundo.

Essas empresas vêm investindo pesado em supercomputadores, tecnologias de resfriamento e servidores otimizados para IA, capazes de suportar milhares de agentes operando simultaneamente.

DA COMPUTAÇÃO GENÉRICA AO SILÍCIO SOB MEDIDA

Sistemas baseados em agentes não operam isoladamente. Eles interagem constantemente com bancos de dados, dispositivos pessoais e até veículos. A inferência – ou seja, a capacidade de gerar respostas a partir do que foi aprendido – é uma exigência constante.

“Os agentes de IA demandam hardware muito mais especializado, capaz de lidar com essa inferência constante”, explica Tolga Kurtoglu, diretor de tecnologia da Lenovo. “Quanto mais rápida a inferência, mais eficiente é a IA – e isso vale tanto para os data centers quanto para os dispositivos.”

Para evitar gargalos, empresas de tecnologia estão colaborando com fabricantes de chips para desenvolver soluções específicas com baixa latência.

A OpenAI está criando seus próprios chips e contratando engenheiros para trabalhar no desenvolvimento conjunto de hardware e software. Já a Meta está otimizando o uso de memória e o processamento em seus aceleradores MTIA e na infraestrutura Grand Teton.

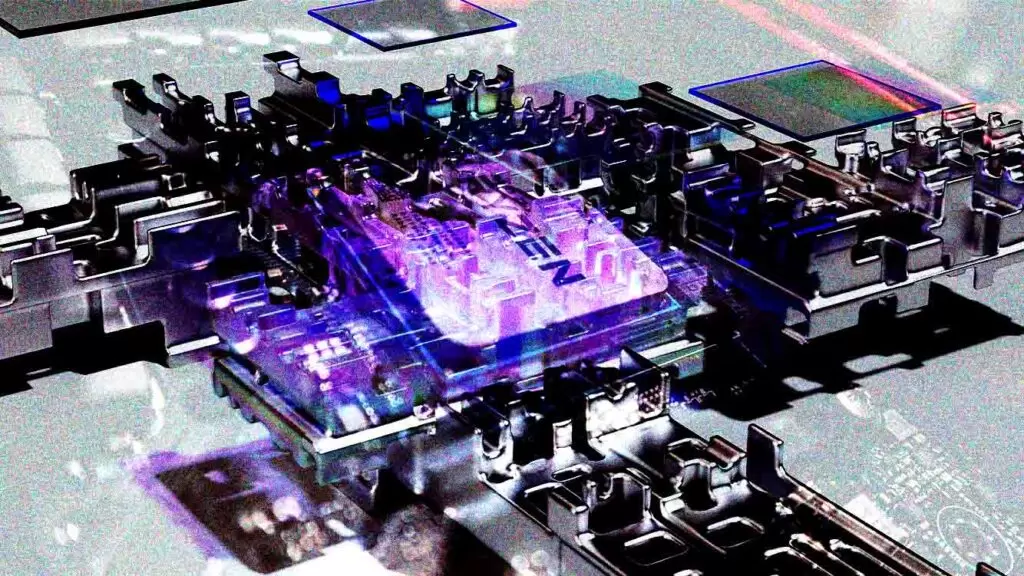

Aceleradores de GPU otimizados para transformers, como a linha Instinct MI, da AMD, além de NPUs (unidades de processamento neural) e SoCs (sistemas em um chip), estão sendo projetados para se adaptar em tempo real.

A AMD, por exemplo, lançou recentemente a série Instinct MI350, voltada para aplicações com agentes de IA, IA generativa e computação de alto desempenho.

Segundo a própria AMD, sete das dez maiores desenvolvedoras de modelos de inteligência artificial do mundo – incluindo Meta, OpenAI, Microsoft e xAI – já estão usando esses chips em suas operações de produção.

MAIS INFRAESTRUTURA COMPUTACIONAL DEMANDA MAIS ENERGIA

Mas, apesar da potência, os sistemas de IA generativa e os agentes de IA consomem muita energia. Um relatório da Universidade de Stanford, nos EUA, estima que o treinamento do GPT-3 exigiu cerca de 1.287 megawatts-hora – o equivalente à produção de uma pequena usina nuclear durante uma hora. Por isso, a eficiência energética se tornou uma prioridade.

“Estamos vendo uma grande demanda por soluções mais modulares, descentralizadas e com maior eficiência energética para aplicações baseadas em agentes.

a comunicação entre máquinas está abrindo caminho para um novo nível de inteligência.

As empresas querem implementar agentes onde faz mais sentido, economizando energia e reduzindo custos”, afirma Mark Lohmeyer, vice-presidente e gerente geral de infraestrutura de computação e IA/ aprendizado de máquina do Google Cloud.

Fornecedoras de infraestrutura, como a Lenovo, já estão oferecendo chips de IA para dispositivos de borda e racks de data center adaptados para inteligência distribuída. Isso permite que os agentes tomem decisões localmente, em tempo real, mantendo a conexão com modelos mais robustos hospedados na nuvem.

À medida que os agentes de inteligência artificial se expandem dos grandes data centers para a borda da rede, a infraestrutura por trás deles também precisa se tornar inteligente, distribuída e autônoma. Nesse novo cenário, a IA deixará de estar apenas no código – ela estará gravada no próprio silício.