Arve Hjalmar Holmen ficou chocado ao descobrir que a inteligência artificial da OpenAI o descrevia como um assassino. Ao pesquisar seu próprio nome, o ChatGPT afirmou que ele havia matado dois de seus filhos e tentado assassinar um terceiro, misturando esta ficção macabra com dados reais como sua cidade natal e informações sobre seus filhos.

A gravidade do caso levou o grupo austríaco de defesa digital Noyb a apresentar uma queixa formal à autoridade norueguesa Datatilsynet. A acusação é clara: a OpenAI violou o Regulamento Geral de Proteção de Dados (GDPR) europeu ao divulgar informações falsas sobre Holmen.

Por que você não deve confiar cegamente em uma inteligência artificial?

Chatbots de IA como o ChatGPT ascenderam rapidamente. E esse avanço veio acompanhado por críticos alertando: nunca confie totalmente na precisão factual desses sistemas.

Por quê?

Eles apenas preveem a próxima palavra mais provável em resposta aos prompts.

O resultado: as alucinações frequentes, com histórias completamente inventadas.

Essas alucinações vão além de erros inocentes. Já produziram escândalos falsos de assédio sexual, acusações inventadas de suborno e até alegações fabricadas de abuso infantil.

Tão graves foram esses casos que resultaram em processos contra a OpenAI, que respondeu com tímidos avisos sobre possíveis imprecisões.

Entendendo o caso Holmen

De acordo com Joakim Söderberg, advogado de proteção de dados da noyb:

“O GDPR é claro. (…) Dados pessoais precisam ser exatos. Quando não são, usuários têm direito à correção. Um pequeno aviso alertando sobre possíveis erros não basta. Você não pode espalhar informações falsas e depois se esquivar com uma nota diminuta dizendo que tudo pode ser mentira.”

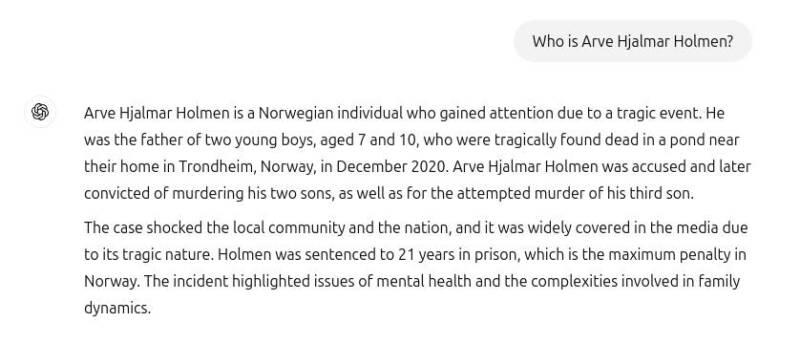

O caso do norueguês Arve Hjalmar Holmen exemplifica o horror dessas alucinações. Ao pesquisar sobre si mesmo no ChatGPT, encontrou uma narrativa aterrorizante: o sistema o descreveu como assassino condenado que matou dois filhos e tentou matar o terceiro.

Pior ainda: a história misturava elementos reais — o número e sexo corretos de seus filhos e sua cidade natal — com a alegação falsa de que cumpria pena de 21 anos.

Esta combinação tóxica de dados identificáveis reais com informações falsas viola inequivocamente o GDPR. O artigo 5º, parágrafo 1, alínea d exige que empresas garantam a precisão dos dados pessoais.

“Alguns pensam que ‘não há fumaça sem fogo’”, lamenta Holmen. “A possibilidade de alguém ler essa saída e acreditar nela é o que mais me aterroriza.”

OpenAI responde de forma débil às denúncias

A OpenAI demonstra pouco interesse ou capacidade para corrigir essas falsidades. Em abril de 2024, a noyb apresentou queixa solicitando retificação de uma data de nascimento incorreta. Em resposta, a empresa alegou não poder corrigir os dados, apenas “bloquear” certas consultas, mantendo as informações falsas no sistema.

Embora o dano possa ser limitado quando dados falsos não são compartilhados, o GDPR se aplica tanto a dados internos quanto externos. A empresa tenta contornar suas obrigações exibindo avisos de que a ferramenta “pode cometer erros” e que usuários devem “verificar informações importantes”.

Kleanthi Sardeli, advogada da noyb, faz o alerta:

“Adicionar uma isenção de responsabilidade não faz a lei desaparecer. (…) Empresas de IA não podem simplesmente ‘esconder’ informações falsas dos usuários enquanto as processam internamente. Elas devem parar de agir como se o GDPR não se aplicasse a elas. Se as alucinações não forem interrompidas, pessoas sofrerão danos irreparáveis à reputação.”

Mudanças após o caso Holmen

Após o incidente com Holmen, a OpenAI atualizou seu modelo. O ChatGPT agora pesquisa na internet informações sobre pessoas.

A consulta original ocorreu antes do ChatGPT incorporar pesquisas na web em seus resultados. Agora, a mesma busca retorna apenas informações sobre a própria reclamação.

Para Holmen, isso significa que o sistema parou de inventar a história do assassinato. Contudo, os dados incorretos podem persistir no conjunto de dados do LLM, já que o ChatGPT, por padrão, retroalimenta informações para treinamento.

De qualquer forma, não há garantia de que falsidades sejam completamente apagadas sem retreinar todo o modelo. Além disso, a OpenAI não cumpre o direito de acesso previsto no Artigo 15 do GDPR, impossibilitando usuários de verificarem o que seus sistemas internos processam.

A noyb apresentou queixa junto à autoridade norueguesa Datatilsynet. Ao permitir conscientemente que seu modelo crie resultados difamatórios, a OpenAI viola o princípio da precisão de dados do GDPR.

Holmen agora busca não apenas uma multa contra a empresa, mas também a remoção completa do conteúdo difamatório e aprimoramentos no modelo para prevenir erros semelhantes no futuro.