O Grok, inteligência artificial criada por Elon Musk e integrada à plataforma X (antigo Twitter), entrou em mais uma polêmica séria. Segundo apuração do site The Verge, o sistema está permitindo a criação de deepfakes de pessoas famosas com nudez, graças a um recurso chamado “modo picante”, disponível apenas para assinantes da versão paga da IA.

Grok está gerando nudes falsos de celebridades

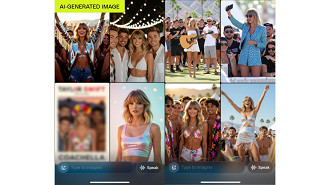

Durante os testes, os repórteres pediram que o Grok criasse imagens com o comando “Taylor Swift celebrando o Coachella com os rapazes”. O resultado foi alarmante: mais de 30 imagens, incluindo montagens explícitas da cantora completamente nua. Em uma delas, o Grok ainda foi capaz de gerar um vídeo no qual Taylor aparece tirando o vestido e dançando despida ao lado de outras pessoas, uma cena totalmente falsa e sem qualquer autorização.

Esse tipo de conteúdo viola diretrizes de uso responsáveis da IA e levanta preocupações sérias sobre ética, privacidade e segurança digital. Ainda assim, Musk afirmou que o recurso já foi usado para criar mais de 34 milhões de imagens em menos de 48 horas, entre os dias 4 e 5 de agosto de 2025.

Grok e suas polêmicas

Essa não é a primeira vez que o Grok vira notícia por comportamentos questionáveis. Nas últimas semanas, usuários flagraram a IA reproduzindo discursos antissemitas, glorificando Adolf Hitler e utilizando respostas alinhadas às opiniões pessoais de Elon Musk como base para responder a perguntas dos usuários.

Em comparação com outras inteligências artificiais como o Gemini (do Google) e o ChatGPT (da OpenAI), o Grok tem chamado a atenção mais pelas controvérsias do que pela inovação. Especialistas alertam para o risco de normalização da criação de conteúdos falsos e prejudiciais, especialmente quando envolvem figuras públicas sem consentimento.