A OpenAI está lançando um novo modelo chamado o1, o primeiro de uma série planejada de modelos de “raciocínio” que foram treinados para responder perguntas mais complexas, mais rápido do que um humano pode. Ele está sendo lançado junto com o o1-mini, uma versão menor e mais barata. E sim, se você está mergulhado em rumores de IA: este é, de fato, o especulado modelo Strawberry,

Para a OpenAI, o o1 representa um passo em direção ao seu objetivo mais amplo de inteligência artificial semelhante à humana. Mais praticamente, ele faz um trabalho melhor em escrever código e resolver problemas multietapas do que modelos anteriores. Mas também é mais caro e mais lento de usar do que o GPT-4o . A OpenAI está chamando este lançamento do o1 de “prévia” para enfatizar o quão incipiente ele é.

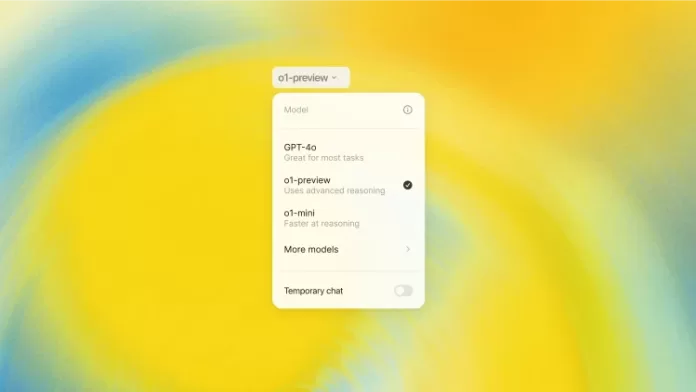

Usuários do ChatGPT Plus e Team têm acesso ao o1-preview e ao o1-mini a partir de hoje, enquanto usuários Enterprise e Edu terão acesso no início da semana que vem. A OpenAI diz que planeja levar o acesso ao o1-mini a todos os usuários gratuitos do ChatGPT, mas ainda não definiu uma data de lançamento. O acesso do desenvolvedor ao o1 é realmente caro: na API, o o1-preview custa US$ 15 por 1 milhão de tokens de entrada, ou pedaços de texto analisados ??pelo modelo, e US$ 60 por 1 milhão de tokens de saída. Para efeito de comparação, o GPT-4o custa US$ 5 por 1 milhão de tokens de entrada e US$ 15 por 1 milhão de tokens de saída.

O treinamento por trás do o1 é fundamentalmente diferente de seus predecessores, me conta o líder de pesquisa da OpenAI, Jerry Tworek, embora a empresa esteja sendo vaga sobre os detalhes exatos. Ele diz que o o1 “foi treinado usando um algoritmo de otimização completamente novo e um novo conjunto de dados de treinamento especificamente adaptado para ele”.

A OpenAI ensinou modelos GPT anteriores a imitar padrões de seus dados de treinamento. Com o o1, ela treinou o modelo para resolver problemas por conta própria usando uma técnica conhecida como aprendizado por reforço, que ensina o sistema por meio de recompensas e penalidades. Em seguida, ela usa uma “cadeia de pensamento” para processar consultas, de forma semelhante a como os humanos processam problemas passando por eles passo a passo.