A inteligência artificial dominou mais uma vez os palcos do South by Southwest (SXSW) 2025, em Austin. Mas, se no ano passado a discussão girava em torno da revolução provocada pelo ChatGPT e seus grandes modelos de linguagem (LLMs), este ano especialistas começam a questionar até onde esses modelos podem nos levar.

A tecnologia que popularizou a IA generativa nos últimos tempos enfrenta desafios claros. Os LLMs exigem quantidades absurdas de energia e água para operar, tornando-se cada vez mais caros e insustentáveis. Além disso, são sistemas estáticos, que não aprendem de forma contínua. Para cada nova atualização, é preciso treiná-los de novo – um processo caro e ineficiente.

Os números refletem essa preocupação. Nos Estados Unidos, estima-se que o consumo de eletricidade por centros de dados triplique até 2028, atingindo 325 terawatts-hora (TWh) – mais do que o consumo anual da Espanha, que é de 246 TWh. O treinamento do GPT-3 liberou 552 toneladas de CO2, o equivalente à emissão de 123 veículos movidos a gasolina em um ano.

Além disso, a refrigeração dos servidores exige grandes volumes de água doce, com algumas estimativas indicando que, até 2027, a IA pode consumir 6,6 bilhões de metros cúbicos de água. Apenas uma sessão média no ChatGPT (de 10 a 50 respostas) pode gastar até meio litro de água.

Para os especialistas, o LLM e o ChatGPT são como os primeiros modelos de trem. Foram bons para provar que o modal de transporte existe, mas não para serem replicados para o futuro. A saída é procurar por fórmulas que impactam menos o meio ambiente.

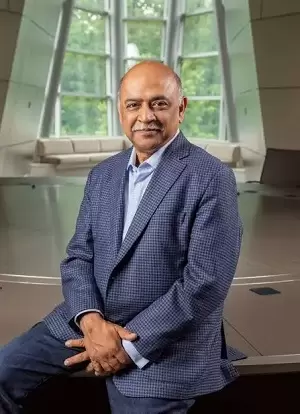

O CEO da IBM, Arvind Krishna, foi mais ousado. Ele prevê que, daqui a cinco anos, a IA usada no mundo “consumirá apenas 1% da energia que usa hoje”. O executivo se apresentou em keynote no salão principal do SXSW.

Na trilha de IA, outros se juntaram para falar das alternativas aos LLMs. A fundadora da Aix.AI e pesquisadora em computação espacial Denise Holt acredita que não há como os modelos atuais continuarem. “Os LLMs vão se tornar obsoletos. São ineficientes e insustentáveis”, afirmou.

Nesta mesma discussão, Peter Voss, cientista-chefe da Aigo.AI e um dos pioneiros da pesquisa em inteligência artificial, disse que, embora o ChatGPT tenha popularizado a ideia de IA, não será ele que levará à evolução da tecnologia. “Os LLMs não são um caminho para inteligência artificial geral. Eles são uma distração e um beco sem saída”.

A provocação de Voss, que cunhou o termo inteligência artificial geral (IAG) nos anos 1990, ecoa um sentimento crescente no setor. Se a IA veio para transformar a sociedade, o modelo atual está longe de ser o ideal. Mas o que pode substituí-lo?

IAs QUE APRENDEM COMO O CÉREBRO HUMANO

Uma das abordagens que mais chamou atenção no festival foi a inferência ativa (ou construtivista). Denise Holt defendeu esse modelo como um caminho viável para criar IAs que aprendem de forma contínua, interagindo com o ambiente, assim como um ser humano faria.

Baseada em teorias da neurociência, a interferência ativa faz a IA aprender com poucos dados, replicando a forma como o cérebro humano aprende e cria informações. “O modelo responde aos dados em tempo real e se adapta ao ambiente a partir de percepções”, explicou a pesquisadora.

O DeepSeek foi apontado por conseguir realizar tarefas avançadas com menos recursos que LLMs tradicionais.

Ele se baseia no princípio da energia livre, uma teoria da neurociência proposta pelo pesquisador Karl Friston. Esse modelo permite que a IA se ajuste dinamicamente à medida que recebe novas informações, eliminando a necessidade de retreinamento massivo.

O impacto disso pode ser profundo. Modelos como esse podem ser aplicados em robôs industriais, assistentes pessoais e sistemas de automação que precisam tomar decisões em tempo real, sem depender de um banco de dados estático.

Se a IA que temos hoje é como um aluno que sempre precisa voltar para a escola para reaprender tudo do zero, a inferência ativa propõe um modelo onde ela aprende de forma incremental, fazendo ajustes conforme interage com o mundo.

A FUSÃO ENTRE APRENDIZADO DE MÁQUINA E RACIOCÍNIO LÓGICO

Outra abordagem defendida foi a IA neuro-simbólica. Enquanto os LLMs trabalham apenas com padrões estatísticos, os modelos neuro-simbólicos buscam combinar redes neurais com raciocínio lógico, permitindo que a IA vá além da simples previsão de palavras e realmente compreenda conceitos.

Peter Voss explicou que essa abordagem pode ser fundamental para alcançar uma IA mais eficiente e confiável. “A IA generativa é ótima para reconhecimento de padrões, mas incapaz de lidar com o inesperado ou de raciocinar logicamente”, apontou.

Os modelos neuro-simbólicos poderiam replicar a capacidade humana de abstração e generalização, algo que os LLMs não fazem bem. Isso significa que, em vez de apenas prever a próxima palavra em uma frase, a IA seria capaz de interpretar e justificar suas decisões.

Essa abordagem pode transformar setores como saúde, finanças e direito, onde não basta reconhecer padrões, mas entender o contexto e fornecer explicações para suas respostas.

MODELOS MENORES E MAIS EFICIENTES

Se, por um lado, novas arquiteturas estão sendo desenvolvidas, por outro, há um movimento forte para reduzir o tamanho e a demanda computacional da IA. O DeepSeek, modelo desenvolvido na China, foi apontado por conseguir realizar tarefas avançadas com muito menos recursos do que os LLMs tradicionais.

a IA que temos hoje é como um aluno que sempre precisa voltar para a escola para reaprender tudo do zero.

“O DeepSeek provou que podemos ter modelos menores e mais eficientes sem comprometer a performance“, disse o CEO da IBM. Krishna argumentou que os avanços recentes provam que é possível reduzir drasticamente o tamanho da IA sem perder desempenho. A longo prazo, isso pode tornar a tecnologia mais acessível e reduzir o impacto ambiental do setor.

Além do DeepSeek, outras empresas estão apostando em modelos modulares e IA específica para domínios, reduzindo o desperdício de recursos computacionais. A ideia é que, em vez de uma IA genérica como o ChatGPT, sejam criados modelos altamente especializados para diferentes setores, como saúde, logística e engenharia.

“Precisamos de modelos de IA específicos para resolver problemas do mundo real – os LLMs generalistas não são suficientes”, disse Krishna. Para os especialistas, o fim da era dos LLMs significa uma transição para sistemas mais eficientes, sustentáveis e especializados.